人类肢体表情能有效传达情绪变化和行动意图,运动学信息在这一过程中不可或缺。然而,现有研究对情绪性肢体运动数据的定量分析还不够深入。此外,现有肢体表情数据集主要通过实验室运动捕捉实现,缺少基于2D视频的自然化肢体表情数据库。

辽宁师范大学脑与认知神经科学研究中心罗文波教授团队联合大连理工大学刘胜蓝副教授团队基于前期工作,构建了基于2D姿势估计的多视角情绪性表情数据库(Multi-view Emotional Expressions Dataset, MEED)。

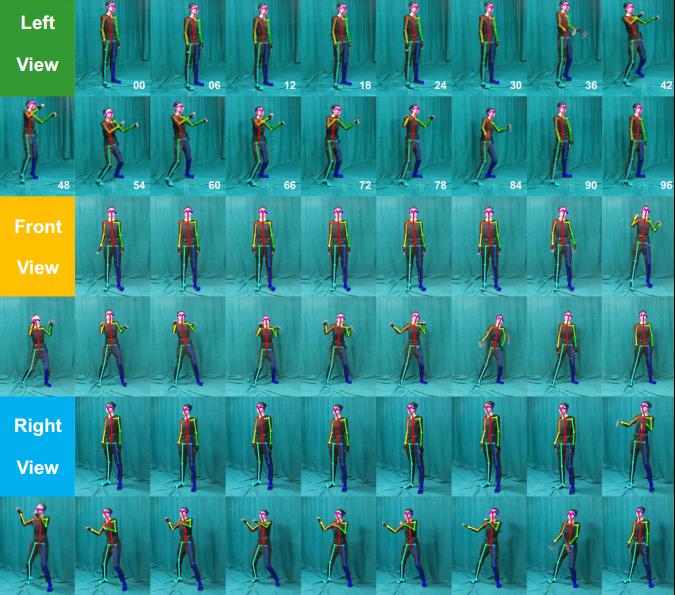

MEED由4102个肢体表情视频的姿势估计结果组成:涉及三种视角(左、前、右)以及六种情绪(愤怒、厌恶、恐惧、快乐、惊讶、悲伤)和中性;通过姿势估计开源项目OpenPose提取每个视频的约97帧图像以及相应关节位置数据,即每帧中25个人体关节点的像素空间坐标(x,y)。

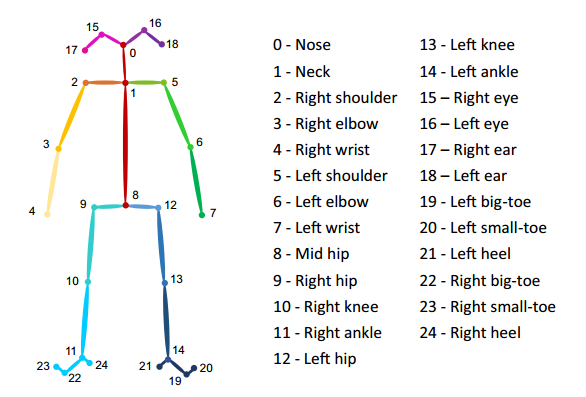

图1 OpenPose模型的25个关键点

MEED包括4102条记录、397809个PNG文件和397809个JSON文件,所有坐标的MAT文件也纳入其中,方便各类软件使用。MEED的质量在无法识别关键点比例、置信水平和客观运动这三个指标中得到了验证,表现出较高的坐标提取有效性、可用性和可靠性。该数据库超过150GB,将促进情感计算、人机交互、社会神经科学、精神病学等多个领域及相关交叉学科的研究。

图2 多视角肢体表情估计的图例

相关成果近期发表于Nature旗下期刊Scientific Data(Q1,5年IF=10.8),脑中心张明明副教授和硕士研究生周亚楠为论文共同第一作者,罗文波教授和刘胜蓝副教授为论文共同通讯作者。

论文信息:

Zhang, M†., Zhou, Y†., Xu, X., Ren, Z., Zhang, Y., Liu, S*., & Luo, W*. (2023). Multi-view emotional expressions dataset using 2D pose estimation. Scientific Data, 10(1), 649. doi: 10.1038/s41597-023-02551-y

相关论文信息:

Zhang, M., Yu, L., Zhang, K., Du, B., Zhan, B., Chen, S., Jiang, X., Guo, S., Zhao, J., Wang, Y., Wang, B., Liu, S*., & Luo, W*. (2020). Kinematic dataset of actors expressing emotions. Scientific Data, 7(1), 292. doi: 10.1038/s41597-020-00635-7

Zhang, M., Yu, L., Zhang, K., Du, B., Zhan, B., Jia, S., Chen, S., Han, F., Li, Y., Liu, S., Yi, X., Liu, S*., & Luo, W*. (2023). Construction and validation of the Dalian emotional movement open-source set (DEMOS). Behavior Research Methods, 55(5), 2353–2366. doi: 10.3758/s13428-022-01887-4